La fiducia nel sapere scientifico sta attraversando un periodo di crisi, influenzata da eventi recenti e dall’emergere dell’intelligenza artificiale. Adam Kucharski, professore alla London School of Hygiene & Tropical Medicine, analizza come la scienza si confronta con l’incertezza e il ruolo crescente delle tecnologie avanzate nella nostra comprensione del mondo.

L’incertezza come motore della scienza

Negli ultimi anni, le crisi sanitarie globali hanno messo in luce il rapporto complesso tra scienza e incertezza. Eventi come le epidemie di Ebola e la pandemia di Covid-19 hanno portato a una percezione diffusa che l’incertezza non sia solo una parte naturale della ricerca scientifica, ma piuttosto un limite intrinseco. Secondo Kucharski, questa visione distorta rende difficile accettare che molte conoscenze scientifiche siano basate su probabilità piuttosto che su certezze assolute.

L’esposizione all’incertezza è aumentata notevolmente; tuttavia, la capacità degli esperti di spiegare i fenomeni è diminuita. Questo porta a una situazione in cui l’incertezza diventa problematica soprattutto nelle decisioni pubbliche durante situazioni emergenziali. In tali contesti, le informazioni disponibili sono spesso incomplete o parziali; ciò costringe i decisori ad agire senza avere prove definitive.

Kucharski sottolinea che anche quando ci sono buone evidenze riguardo a un problema specifico o agli strumenti per affrontarlo, possono sorgere disaccordi sulle politiche da adottare. È fondamentale quindi approcciare l’incertezza come un processo multilivello: cercare risposte certe può rivelarsi utopistico.

La questione della verità unica

Il concetto di “weak evidence” descrive situazioni in cui si dispone solo di indizi parziali per prendere decisioni urgenti. In ambiti delicati come quelli sanitari o legali, aspettare prove definitive potrebbe risultare fatale. Pertanto è necessario decidere con le informazioni disponibili bilanciando rischi ed errori potenziali.

Kucharski osserva che questa complessità emerge anche nei processi a lungo termine come il cambiamento climatico: nonostante ci sia consenso scientifico sull’urgenza del problema ambientale, le politiche rimangono frammentate a causa delle divergenze sugli interessi politici e sui valori socialmente condivisi.

Inoltre, il relativismo culturale influisce sulla percezione dell’incertezza nel tempo: ciò che era considerato ovvio ha subito variazioni significative attraverso i secoli e tra diverse culture geografiche. Ad esempio, mentre gli europei storicamente rifiutavano numerazioni negative per ragioni geometriche greche, queste erano comunemente accettate in Asia legandosi alla pratica del debito.

L’impatto dell’intelligenza artificiale sulla conoscenza

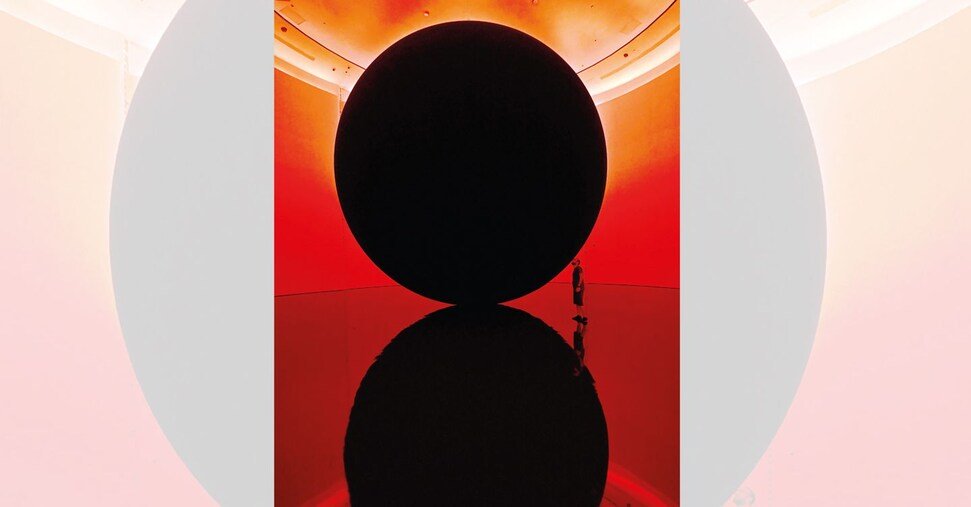

L’uso crescente dell’intelligenza artificiale solleva interrogativi sul nostro rapporto con la verità scientifica. Gli algoritmi attuali possono generare contenuti autonomamente ed effettuare previsioni complesse senza rendere chiaro il processo logico dietro ai risultati ottenuti. Questo porta a domande epistemologiche fondamentali: possiamo fidarci dei risultati prodotti da algoritmi se non comprendiamo appieno il loro funzionamento?

Kucharski mette in guardia sul rischio insito nell’affidarsi ciecamente all’AI; gli algoritmi potrebbero cercare risposte conformistiche piuttosto che quelle più accurate semplicemente per compiacere chi li utilizza. Ciò crea due tipi di rischio: uno tecnico legato alla difficoltà di valutazione dell’affidabilità degli algoritmi stessi e uno concettuale poiché ci abituiamo ad accettare soluzioni senza governarne realmente il processo decisionale.

In questo contesto storico unico della conoscenza umana emerge quindi una nuova figura culturale rappresentata dall’intelligenza artificiale: non solo uno strumento al servizio delle nostre necessità ma anche un soggetto capace di influenzarne profondamente i confini stessi.